Os desafios anteriores do golfe na rede neural ( isso e aquilo ) me inspiraram a apresentar um novo desafio:

O desafio

Encontre a menor rede neural de avanço de forma que, dado qualquer vetor de entrada quadridimensional com entradas inteiras em , a rede produza a com um erro coordenado estritamente menor que .

Admissibilidade

Para esse desafio, uma rede neural feedforward é definida como uma composição de camadas . Uma camada é uma função que é especificada por uma matriz de pesos , um vector de viés , e uma função de activação que é aplicada coordinate- sensato:

Como as funções de ativação podem ser ajustadas para qualquer tarefa, precisamos restringir a classe de funções de ativação para manter esse desafio interessante. As seguintes funções de ativação são permitidas:

Identidade.

ReLU.

Softplus.

Tangente hiperbólica.

Sigmoide.

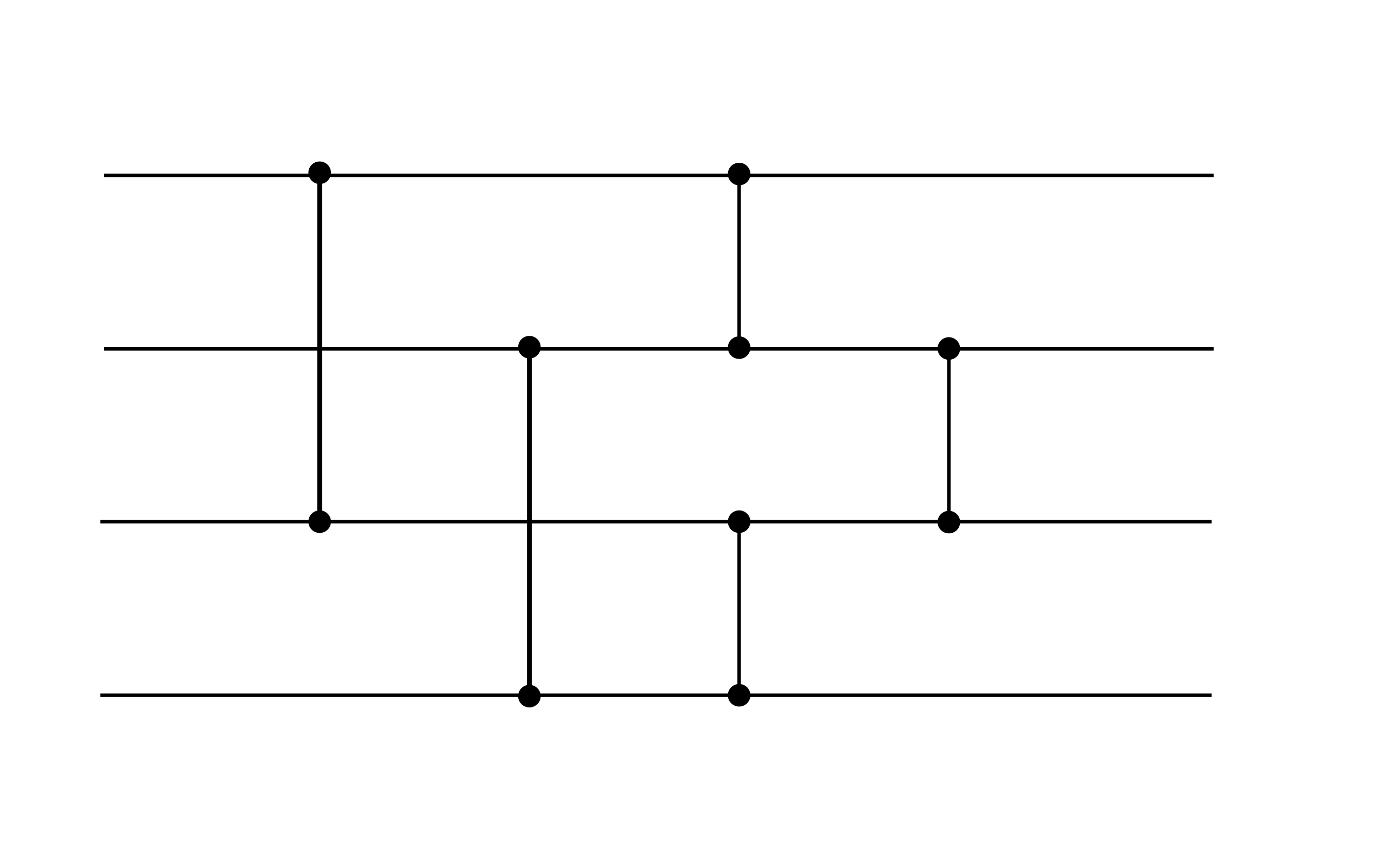

Em geral, uma rede neural admissível toma a forma para alguns , onde cada camada é especificada por pesos , polarizações , e uma função de activação da lista acima. Por exemplo, a seguinte rede neural é admissível (embora não satisfaça a meta de desempenho desse desafio, pode ser um gadget útil):

Este exemplo exibe duas camadas. Ambas as camadas têm viés zero. A primeira camada usa a ativação ReLU, enquanto a segunda usa a ativação de identidade.

Pontuação

Your score is the total number of nonzero weights and biases.

(E.g., the above example has a score of 16 since the bias vectors are zero.)